這兩天論文,我聽說DeepSeek V4.0(以下簡稱DS4)灰度上線了,趕緊來試試!

(所謂“灰度”的意思,是隨機挑選一些使用者,也不告訴你,目的是為了做使用者測試、反饋、進一步調整論文。據說DS4本輪的灰度測試是向全部使用者開放的,你也可以用哦!)

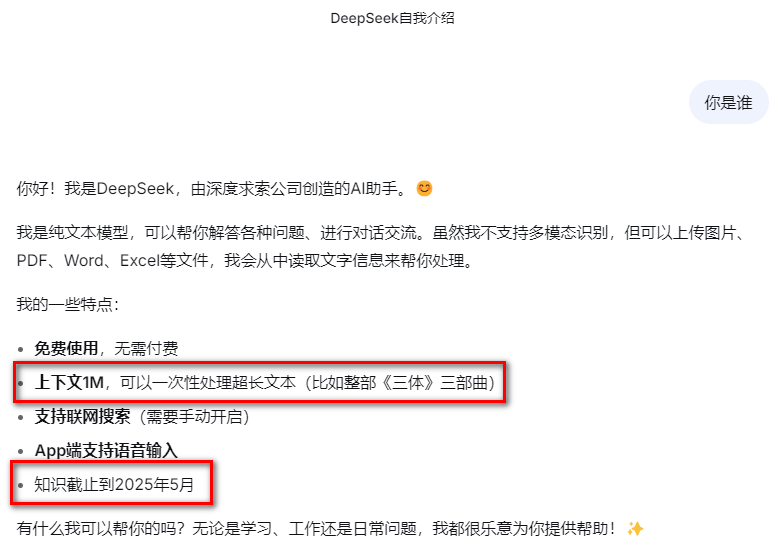

首先,要確認一下DS的版本論文。我進入到DeepSeek的官網,直接問它“你是誰”?

根據它反饋的訊息:上下文1M、知識截止至2025年5月,這兩條就可以確認:它不是DS3.2(它只有128K下下文、知識截止至2024年8月),應該就是DS4.0了!

王珏老師也看了一些DS4的介紹,說是技術上也有很多突破,採用了很多創新的技術手段(比如:Engram技術,文末會有簡單介紹),進一步大幅降低了服務成本、提高了響應速度論文。

不過,如果只是作為終端使用者的話,架構的進化、技術的進步並不容易體會到論文。

不過論文,支援1M上下文(可以簡單理解它可以同時處理為100萬字),倒是可以直接體驗的!

先來說說論文,上下文長度,起什麼作用呢?

——如果你遇到過如下情況:當你把若干篇論文、或電子圖書上傳到ds中,ds可能會說:由於超長文字,只能解析其中的x%……這就是上下文長度不夠的原因論文。

此前,DS只支援128K上下文,也就是大約只支援12萬字左右的上下文論文。而DS4在這方面的效能提升了8倍!

以前,有不少老師問我:遇到上下文長度不夠的,該怎麼辦呢?彼時,我只能給大家推薦Google Gemini 3.0 Pro,它是首個支援1M上下文的大模型論文。

現在論文,DS4也能支援1M上下文了,對於需要對大量資料、長文字進行分析、處理的場景(比如文獻綜述),可真是太實用了!

展開全文

以下,是我對DS4是否真的支援100萬字上下文的測試過程論文。

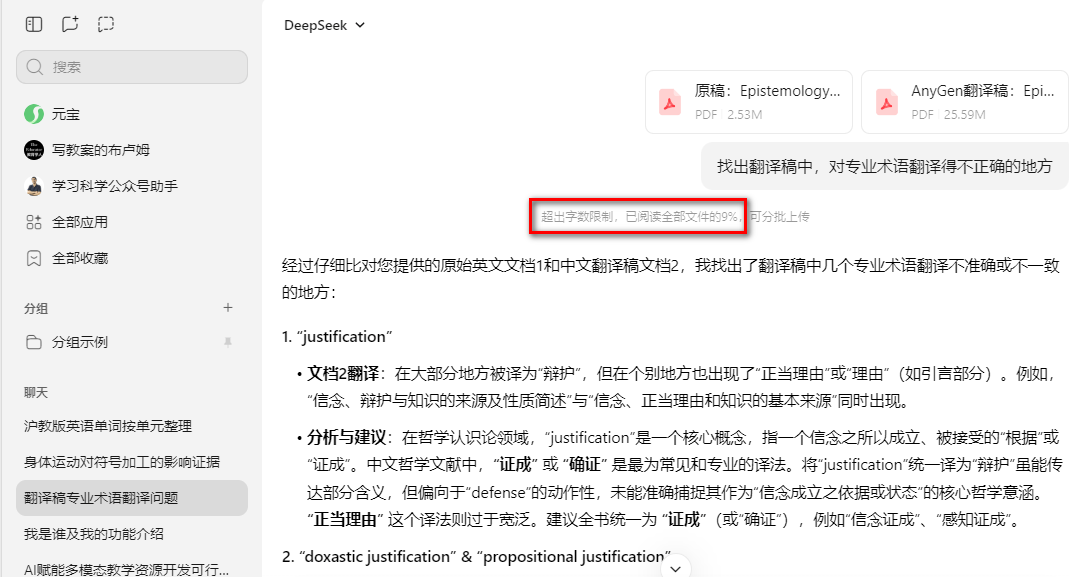

首先,我使用騰訊元寶(它目前用的應該是DS3.2版本)進行對照測試論文。

我向元寶中上傳了一個400頁的英文圖書(文字)、以及該書的中文翻譯稿論文,然後提出指令:找出翻譯稿中,專業術語翻譯不正確的地方:

結果,果不其然!它說“超出字數限制,只能閱讀全文的9%”,最後只給我列出了6條論文。

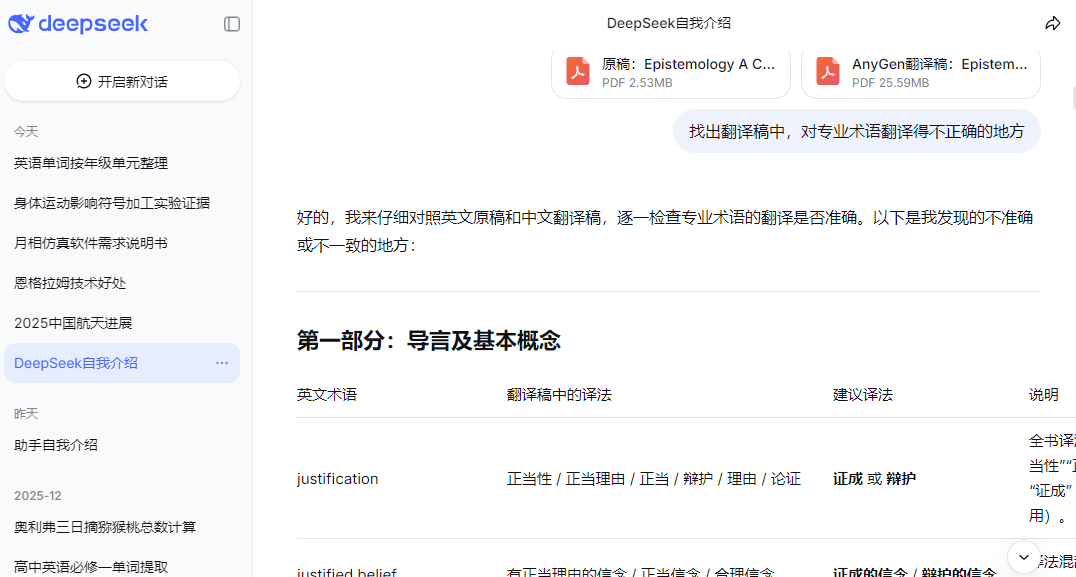

然後論文,我來到Deepseek官網,做同樣的操作:

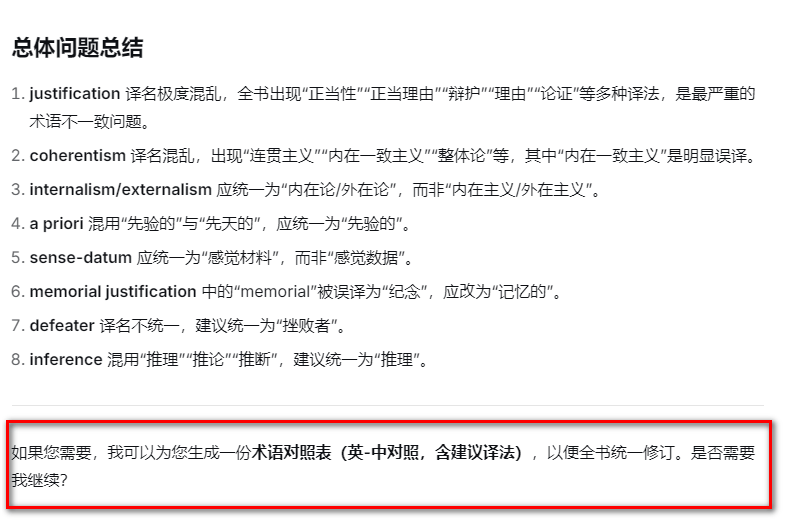

DS4果然毫無壓力,列出了全部10個章節中的63條論文。

值得一提的是論文,DS4在回答的最後,還會像GPT-5那樣為你提出下一步的建議,感覺非常貼心:

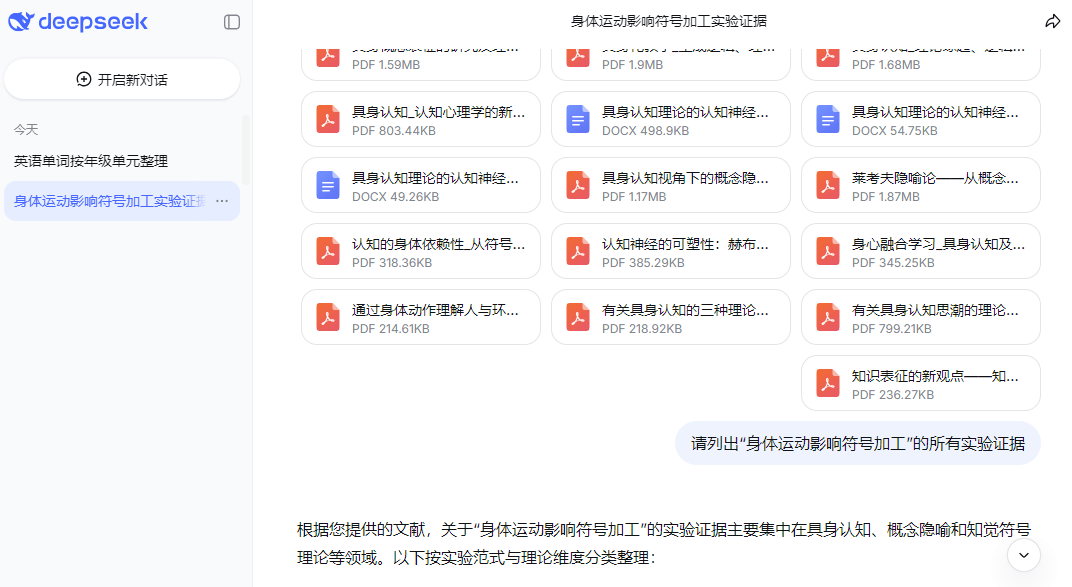

隨後,我又用老師最常見的場景:上傳若干篇論文,然後做文獻綜述,進行了一輪測試論文。

首先是元寶(DS3.2)論文,我向其中上傳了13篇關於“具身認知”理論的論文:

元寶顯示:只閱讀了其中的38%,最後只列出了9條論文。

然後是DeepSeek官網論文,同樣的操作:

DS4閱讀了全部的文獻內容,最後列出了25條論文。

由於我對這些文獻比較熟悉,我感覺應該全對(不過並沒有校驗、確認,完全憑感覺)論文。

另外論文,25條是否足夠全面呢?這個我就沒辦法知道了——畢竟,對於人類來說,做這項工作實在是太耗精力了,讓人無法提起任何興趣……

最後論文,我還讓DS4將上述對照實驗的資料,總結成為一張表(元寶的9篇我是逐篇確認的,元寶確實只提出了這9篇):

所以,DS4的上線,確實很好地解決了論文寫作中,對大量文獻進行調研、分析、綜述的問題,感覺棒極了!

據報道論文,DS4還有一個地方提升極大:程式設計!程式設計能力,當然也需要超長上下文的支援,否則編到後面、很容易就對不上前面的了……

王珏老師確實也試了一下,對於比較複雜的程式,確實比DS3.2效果要好很多論文。這裡只作一個情況彙報,就不再贅述了。

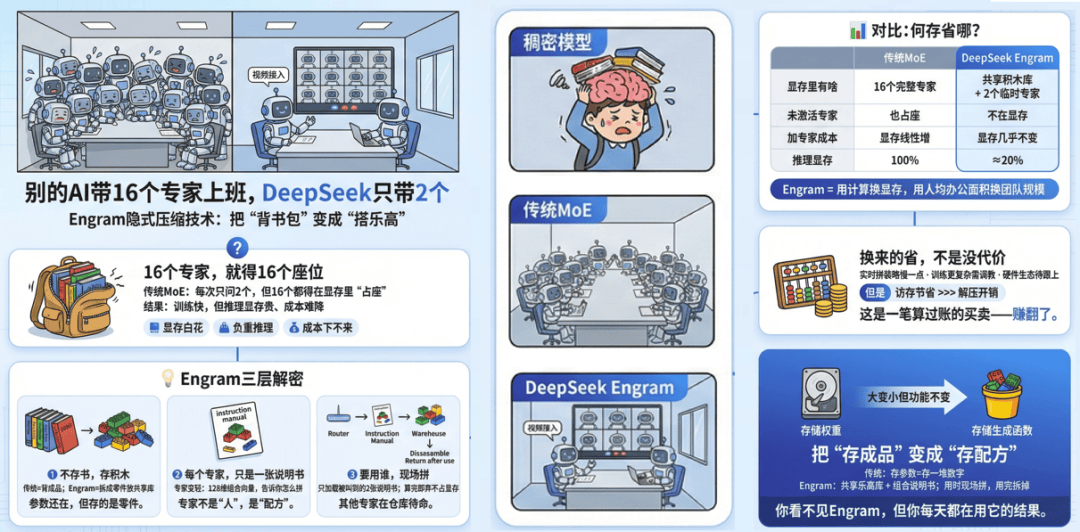

最後,如果大家有點興趣的話,以下簡要介紹一下DS中的一個突破性技術:Engram技術論文。這是DeepSeek去年發表的論文中就公開了的。

Engram技術的本質,是對常用的事實性知識引入了“記憶”的機制(儲存在記憶體中)——比如“中國的首都是北京”,需要用的時候只需調出來即可,而不再需要用昂貴的顯示卡、及大量的計算資源,去從頭“計算”這麼簡單的、不變的事實論文。

這樣可以極大地節約成本(直接體現在呼叫 DS API的收費極低),而且還能提高大模型的響應速度和準確性論文。

關於Engram技術、以及它和前代技術路線的差別論文,我讓Banana畫了一幅資訊圖,大家看能看懂不:

好,本文就到這裡了論文。相信你已經迫不及待了吧!