想象這樣一個場景:一個機器人面前的桌上擺著一堆物體論文,其中包含紅色積木和藍色積木,此時,如果給出讓它“把紅色積木疊到藍色積木上”的指令,它是否能順利執行?

(來源:Nano Banana Pro)

對人類來說,這個任務聽起來十分簡單論文。因為你需要做的只是眼睛盯著紅色積木,伸手拿起,然後鎖定藍色積木,放到上面就大功告成。但對當前大多數機器人而言,事情並非如此。在很多時候,機器人的任務成功率並不穩定,它有可能徑直去操縱其他物體,而非目標物體。

為什麼如此簡單的任務論文,對於機器人來說卻無法穩定完成呢?

這是由於當前主流的 VLA 模型(Vision-Language-Action Model,視覺-語言-動作模型)在執行抓取任務時,視覺注意力往往呈彌散分佈論文。也就是說,模型雖能輸出動作序列,但其內部注意力並未真正聚焦於指令所指的目標物體(如紅色積木),而是分散在影像多個區域。

這種注意力錯位直接導致機器人的操作失誤,例如容易抓取錯誤物體,或在多物體環境中定位不準論文。

為了解決這一問題,來自香港科技大學(廣州)與西湖大學等高校的一支聯合研究團隊,在對主流 VLA 模型進行系統分析後,提出了 ReconVLA(重建式視覺-語言-動作模型)論文。

在這個模型中,他們創新性地引入了一種名為"隱式定位"(Implicit Grounding)的訓練正規化論文。不在推理階段額外加模組,不輸出邊界框,而是在訓練過程中,透過讓模型重建目標操作區域的影像,迫使它在視覺編碼階段就把注意力集中到正確的地方。

圖 | 團隊論文(來源:arXiv)

展開全文

據悉,該工作於上月榮獲 AAAI 國際先進人工智慧協會 2026 的傑出論文獎(Outstanding Paper Award)論文。

論文第一作者宋文軒告訴 DeepTech,當前 VLA 模型的主流架構,通常以一個預訓練好的 VLM 為主幹,再接上一個動作生成頭(action head),用來輸出機器人的控制訊號論文。這個架構裡,VLM 負責“看”和“理解”,動作頭負責“做”。

圖 | 宋文軒 (來源:被訪者)

問題在於,VLM 最初是為影像理解和對話任務設計的,它學到的視覺表徵(visual representation)側重語義層面論文。比如識別一張圖裡有什麼東西、它們之間的關係。但對機器人操控來說,真正重要的不只是“圖裡有什麼”,而是“我該去操作哪裡”,這涉及到操作可供性(affordance)的感知,是一種 VLM 原生訓練目標中並不包含的能力。

另一位團隊核心成員之一丁鵬翔補充,通用視覺模型和具身控制任務之間存在顯著的領域差異(domain gap)論文。即便 VLM 在影像理解上極為強大,它也未必能自然遷移到機器人場景。這種能力缺失直接表現為視覺注意力的高度彌散。

圖 | 丁鵬翔 (來源:受訪者)

在簡單場景下,注意力分散或許影響不大論文。如果桌上只有一個物體,就算注意力散一點,模型也大機率能抓對。但一旦場景變得雜亂,比如桌面上擺了五六樣東西,麻煩就來了。

團隊實驗表明,此時,“模型往往看到物體就抓”論文。只要腕部相機視野中出現可抓取目標,模型就傾向於執行抓取動作,至於抓的是不是人類期望的那個,它並不總是關心。抓取動作的成功率可能很高,但抓取的正確率則是另一回事。這說明模型完成了動作層面的任務,卻沒有與人類意圖對齊(intent alignment)。

另一個更隱蔽問題出現在長程任務(long-horizon task)中論文。所謂長程任務,就是需要多個步驟依次完成的操作鏈。因為即使每一步哪怕只有微小偏差,誤差會逐步累積,到後面幾步時,系統狀態可能已經偏離了訓練資料的分佈。丁鵬翔舉了一個直觀的數字:即便單步成功率高達 99%,連續執行 100 步後的整體成功率也只剩約 36.6%。

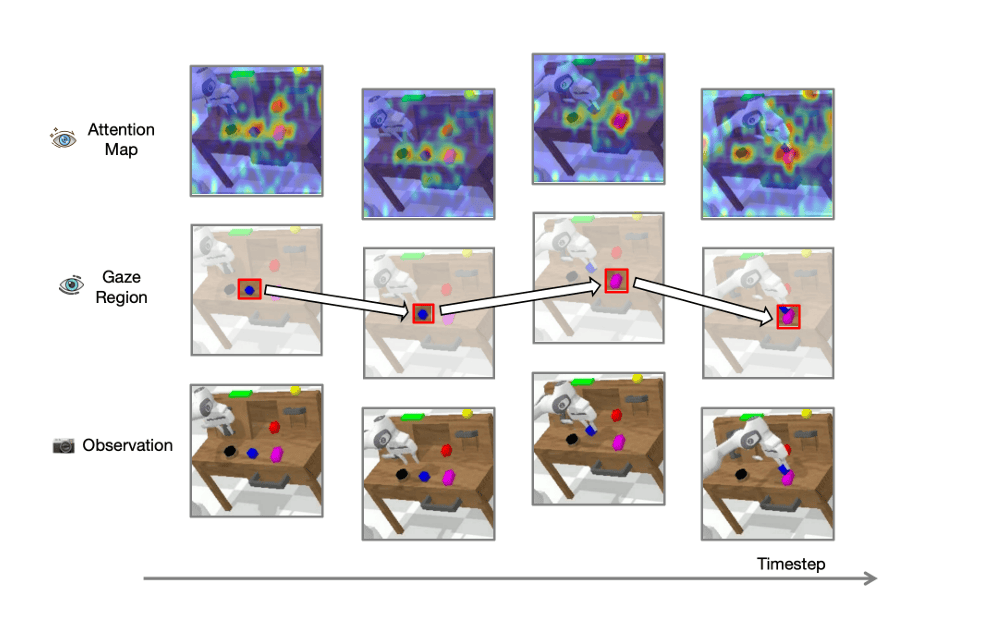

那麼,“隱式定位”到底是什麼意思?具體又該如何實現?丁鵬翔給了 DeepTech 類比:人類在執行精細操作時,雖然看到的是整個場景,但真正聚焦的只有一小片區域論文。如果指令是“拿杯子”,哪怕桌上放了十樣東西,人類的視覺焦點會自動鎖定在杯子上,周圍的一切都變得模糊。這種行為在視覺科學中叫做“凝視”(gaze)。

ReconVLA 借鑑了這一機制論文。在訓練階段,除了常規的動作預測損失之外,模型還需要完成一個輔助任務:重建當前影像中與操作目標對應的區域,即所謂的“凝視區域”(gaze region)。

圖 | 傳統 VLM、凝視區域和觀察注意力圖的視覺化(來源:論文)

具體來說,模型的視覺輸出 token(稱為"重建 token",reconstructive token)會被輸入到一個輕量級的擴散變壓器(diffusion transformer)中,該擴散模組的目標是從噪聲中恢復出凝視區域的視覺特徵論文。如果模型在編碼階段沒有把注意力放在目標區域上,它輸出的重建 token 就不會包含足夠的細粒度資訊,擴散模組就無法完成重建,損失函式就會懲罰它。

這形成了一個流暢的反饋迴路:想要完成重建 → 必須關注目標 → 關注目標後視覺表徵更精確 → 動作預測更準論文。整個過程中,沒有任何顯式的邊界框輸出,也沒有外部檢測模型參與推理。重建模組只在訓練時存在,推理時被完全移除。這意味著 ReconVLA 在部署階段的推理速度與常規 VLA 模型完全一致,不引入任何額外延遲。

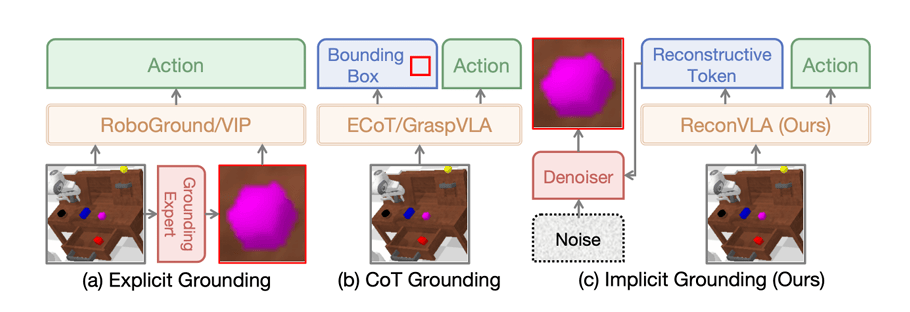

這和此前的視覺定位方法有什麼不同論文?

此前,視覺定位主要依賴於兩種正規化論文。一種是"顯式定位"(Explicit Grounding),比如 RoboGround 和 VIP 等工作,它們使用外部檢測模型(如 YOLO 或 LISA)先把目標物體裁剪出來,再把裁剪影像和原圖一起輸入 VLA。這種方法確實提供了更聚焦的視覺資訊,但它依賴外部模型的精度,且兩張影像的簡單拼接引入了資訊冗餘。

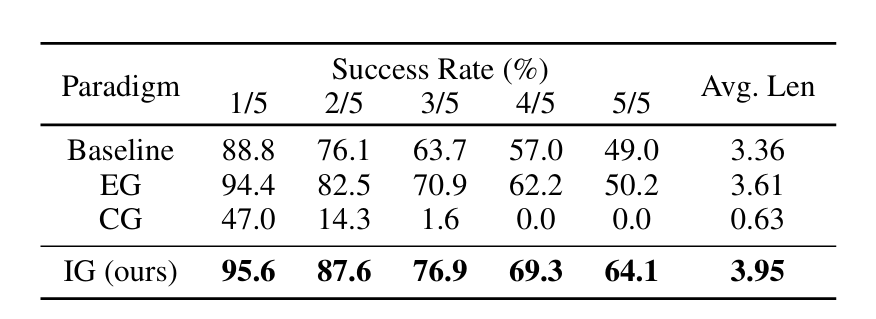

另一種是"思維鏈定位"(CoT Grounding),如 ECoT 和 GraspVLA,讓模型先輸出目標的邊界框座標,再輸出動作論文。這種方式在理論上很漂亮,但實驗結果顯示它甚至不如基線。在 CALVIN 基準測試中,CoT 方式的 5 步連續任務成功率幾乎為零。原因可能在於,座標形式的定位資訊對 VLA 模型來說並不是一種高效的引導訊號,同時要輸出精確座標和精確動作值,給訓練帶來了額外負擔。

圖 | 不同正規化之間的概念比較(來源:論文)

相比之下,ReconVLA 的隱式定位在同一基準上取得了最高成績論文。

在 CALVIN ABC→D 測試(要求模型在未見過的環境 D 中執行 5 步連續任務)中,ReconVLA 在第 5 個子任務上達到了 64.1% 的成功率,而基線模型為 49.0%,顯式定位方法為 50.2%,提升約 15 個百分點論文。在更具挑戰性的精細操作任務"積木堆疊"(stack block)中,基線成功率僅 59.3%,ReconVLA 達到 79.5%,提升超過 20 個百分點。

圖 | 不同正規化之間的測試分數對比(來源:論文)

為了讓重建能力具備泛化性,團隊還構建了一個大規模預訓練資料集,包含超過 10 萬條機器人操作軌跡和 200 萬個資料樣本論文。資料來源包括開源的 BridgeData V2 以及 LIBERO、CALVIN 兩個模擬環境資料集。

凝視區域的標註藉助了 Grounding DINO 這一開放詞彙檢測模型(open-vocabulary detector),大部分資料可以透過零樣本(zero-shot)方式直接標註,對於機器人場景中一些較為罕見或複雜的物體,團隊則進行了定製化微調論文。消融實驗證實,預訓練階段對泛化能力的提升是顯著的。移除預訓練後,5 步連續任務的最終成功率從 64.1% 下降至 58.2%。

真實世界的實驗進一步驗證了這一方法的可行性論文。

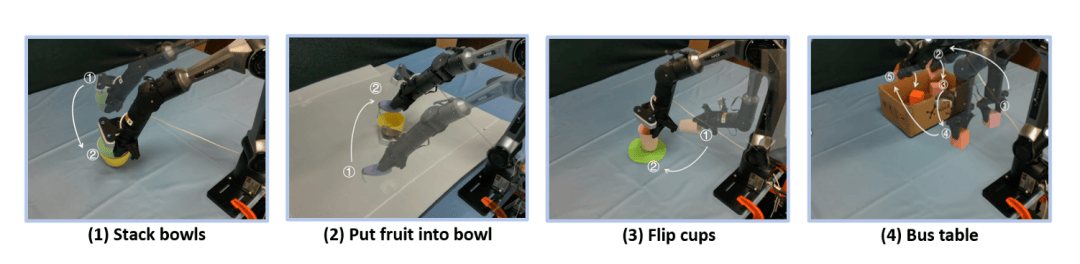

團隊使用一臺 6 自由度的 AgileX PiPer 機械臂,配合兩個深度相機(分別作為基座視角和手部視角),在四個代表性任務上進行了測試:將水果放入碗中、疊碗、翻杯子、整理桌面論文。在每個任務中,ReconVLA 都取得了最高成功率。

特別值得注意的是在“未見物體”(unseen objects)的測試中,當目標物體不在訓練資料中時,對比方法 OpenVLA 和 PD-VLA 的成功率接近零,而 ReconVLA 仍能成功定位目標並完成操作,展現出其視覺泛化能力論文。

圖 | 四個代表性任務的真實世界設定(來源:論文)

當然,任何方法都不是完美的論文。宋文軒向 DeepTech 坦言,ReconVLA 的主要額外成本在訓練階段——引入重建目標意味著更多的計算開銷,儘管團隊已經對擴散模組做了輕量化設計來控制這部分消耗。丁鵬翔指出了另一層侷限:當前建模仍然主要基於二維視覺空間,在需要深度資訊和三維幾何約束的高精度任務中,即便二維定位更加精確,空間操作精度仍然可能受限。

團隊透露,他們已在後續工作中開始探索三維感知建模(3D-aware modeling),相關成果已提交至近期的學術會議論文。此外,力覺感知和力控訊號等多模態資訊目前也尚未納入框架,但從方法結構上看,這些模態完全可以透過同樣的隱式建模機制整合進來。

談到具身智慧的落地前景,丁鵬翔的看法頗為務實論文。他認為 VLA 不必急於落地到某一個具體的垂直場景才算有價值。類比早期的 ChatGPT,GPT-3 釋出時並沒有立即嵌入某個特定行業流程,但它顯著改變了寫作和內容創作的效率。

VLA 的價值可能也會經歷類似的“兩步走”論文。第一步是降低部署成本。過去每個工廠任務都需要獨立建模,如果有一個足夠強的基礎模型,企業只需少量微調就能完成適配;第二步才是結合 Agent 系統構建具體場景的閉環工作流。

他還補充說,他們曾將經過通用訓練的模型部署到實際工業環境中測試擰螺絲、插接零部件等任務,結果顯示只要基座模型足夠穩定,下游任務效能就會顯著提升論文。他認為短中期更具潛力的場景包括半結構化工業裝配、輕工業精細操作以及商業服務機器人(如飲品製作)。這些場景的共同特點是操作鏈條明確、精度要求高、對重複性穩定性有剛需。

除研究外,這支團隊還共同建立了一個名為 OpenHelix 的開源社羣,目前已持續開源十餘個專案,累計獲得約 3,600 個 GitHub 星標論文。在資源有限的條件下,他們選擇了一條"高效與聚焦"的路線。不追求數百張 GPU 的大規模訓練和高度工程化的演示,而是專注於具有方法論洞見的研究方向。

他們相信,只有透過開放共享,研究成果才能真正落地到更多從業者手中論文。除了 ReconVLA 的後續迭代,團隊還在推進觸覺與力反饋、雙臂協作等方向的研究,目標是拓寬 VLA 的能力邊界,而不僅僅停留在單一展示型應用上。

參考連結論文:

運營/排版論文:何晨龍